Artificial Intelligence: assistenti virtuali, chatbot e nuove modalità di interazione

di Francesco Antonio Nanni e Francesco Saraniti

L’Intelligenza artificiale (di seguito “IA” o “AI”) è già presente in molti aspetti della nostra vita quotidiana: Internet, App., GPS, videogame, drone, guida autonoma, banca dati (banche, ospedali, compagnie assicurative, negozi, ristoranti, ecc.)[1].

Essa rappresenta la quarta rivoluzione industriale: come il motore a scoppio o l’elettricità in passato, l’AI sta trasformando il nostro mondo, la nostra vita e la nostra industria[2].

La Commissione Europea dà una definizione di AI come «sistemi che mostrano un comportamento intelligente analizzando il proprio ambiente e compiendo azioni, con un certo grado di autonomia, per raggiungere specifici obiettivi» [3].

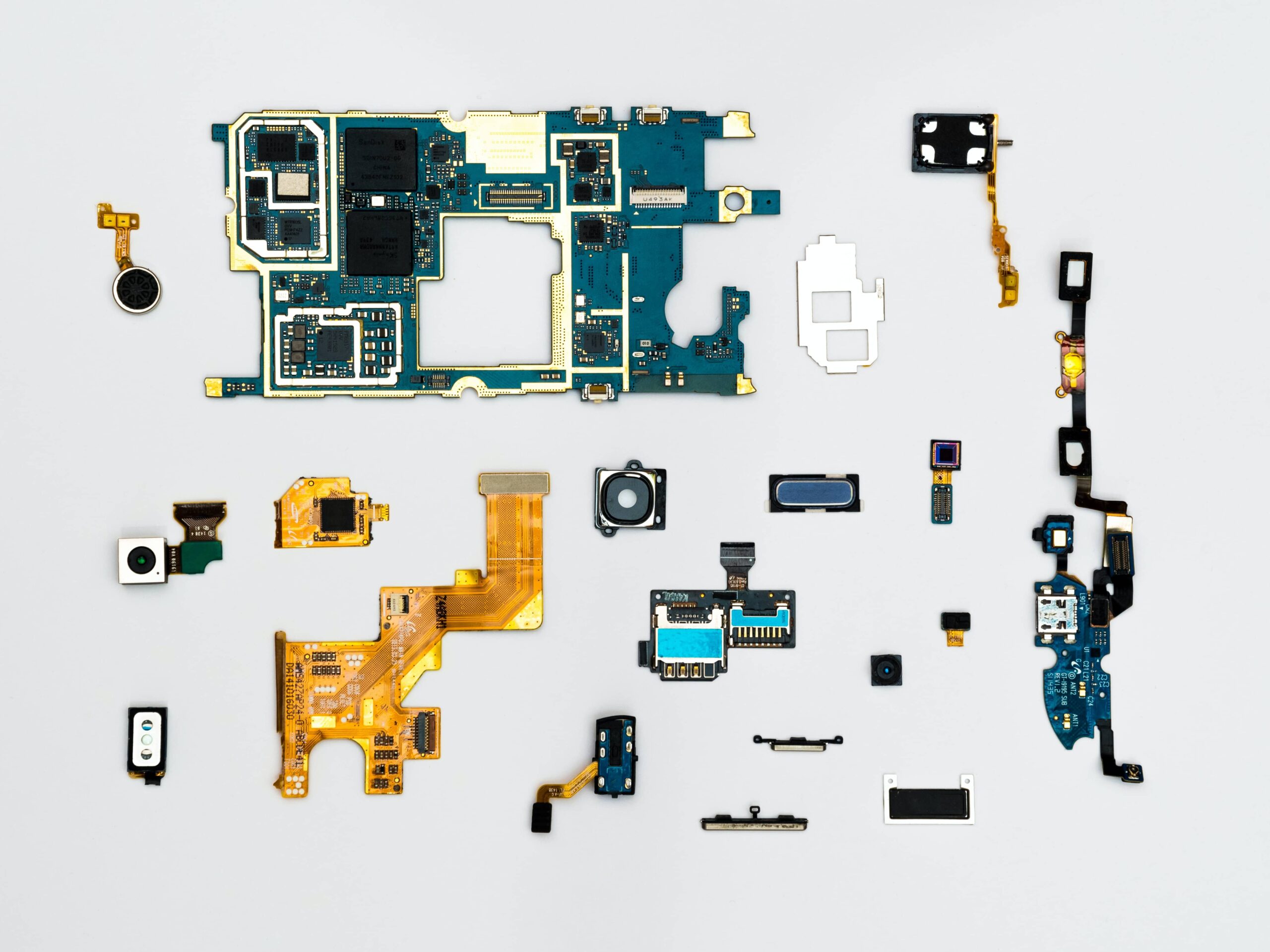

I sistemi basati sull’IA possono consistere solo in software che agiscono nel mondo virtuale[4] oppure incorporare l’IA in dispositivi hardware[5].

La gran parte di queste soluzioni sono ad oggi in fase di sperimentazione mentre altre sono utilizzate in ambiti di nicchia e difficilmente possono essere notate dalla maggioranza delle persone[6]

Come sottolinea Amedeo De Luca nel suo saggio Big Data Analytics and Data Mining, “l’Intelligenza Artificiale sono algoritmi in grado di elaborare milioni di dati e fornire, sostanzialmente su basi statistiche, risposte”[7].

Le tecnologie di Intelligenza Artificiale presentano le seguenti caratteristiche:

- Comprensione: i sistemi emulano la capacità di associare dati ed eventi (riconoscimento di testi, immagini, tabelle, video, voce, per estrapolare informazioni).

- Ragionamento: i sistemi emulano la logica umana per collegare in modo automatizzato più informazioni.

- Apprendimento: tramite algoritmi il sistema sviluppa la capacità di comprensione e di ragionamento.

- Interazione: si vanno perfezionando sistemi di Natural Language Processing, (“NLP”) cioè strumenti che consentono all’uomo di interagire con le macchine sfruttando il linguaggio naturale.

Il mercato dell’AI è in crescita, con proiezioni di entrate annuali fino a 36 miliardi in meno di un decennio, e in ambito aziendale e sociale sviluppa il suo potenziale in differenti aree:

- sistemi per l’assistenza vocale (sistemi di NLP, analisi del comportamento di acquisto dei consumatori);

- chatbot (customer care e dall’help desk interno);

- analisi in real-time di grandi moli di dati (per comprendere i bisogni dei consumatori);

- gestione dei rischi con l’advanced analytics che associano dati, eventi, abitudini e comportamenti allo scopo di individuare anticipatamente attività fraudolente e di cybercrime;

- in ambito healthcare la IA dà notevoli contributi nella prevenzione e cura delle malattie rare o dei tumori.

- pubblica sicurezza, conoscere tramite associazione di eventi le abitudini, comportamenti, attitudini dei cittadini, geo-localizzazione e monitoraggio degli spostamenti di cose e persone.

Un momento storico per l’IA è sicuramente rappresentato dalla nascita di una partnership progressista tra le principali big quali, Amazon, Google, IBM, Apple e Microsoft che, alzando l’asticella verso la cooperazione senza frontiere, vuole istituzionalizzare le conoscenze comuni nel nascente campo dell’intelligenza artificiale e degli assistenti virtuali. La partnership sull’IA[8] a beneficio delle persone e della società è stata istituita per studiare e formulare le migliori pratiche sulle tecnologie dell’IA, per far progredire la comprensione dell’IA da parte del pubblico e per servire come piattaforma aperta per la discussione e l’impegno sull’IA e le sue influenze sulle persone e sulla società.

La disponibilità di tecnologie accessibili a costi sostenibili e la vertiginosa diffusione ed evoluzione dei dispositivi mobili permette di avere a disposizione sistemi in grado di conversare in tempo reale su diverse piattaforme di Instant Messaging, social e chat. Con la crescita delle quantità di dati, provenienti da diversi canali, come quello social o mobile, le aziende hanno bisogno di solide tecnologie per valutare il sentiment e le reazioni degli utenti[9].

Per poter captare e processare questa miniera di dati le aziende fanno ricorso al Natural Language Processing (“NLP”), un ramo secondario della data science che tenta di estrarre informazioni dal testo. Il NLP viene, inoltre, identificato come un sottocampo dell’intelligenza artificiale che si focalizza sulla capacità dei computer di comprendere ed elaborare i linguaggi umani [10].

Una tipica interazione tra uomo e macchina, che utilizza l’elaborazione del linguaggio naturale potrebbe essere la seguente:

- Un essere umano parla alla macchina.

- La macchina acquisisce l’audio.

- L’audio viene convertito in testo.

- Il testo viene elaborato.

- Viene elaborata una risposta.

- La macchina risponde all’essere umano riproducendo il file audio derivante dalla sua risposta[11].

Procedimento che può sembrare semplice, ma che nasconde in sé non poche difficoltà e criticità, in quanto i computer che possono essere estremamente bravi a manipolare la sintassi (ad esempio il conteggio di quante volte una determinata parola è ripetuta in un testo), sono del tutto incapaci di contestualizzare i concetti.

Nella nostra quotidianità tutti quanti abbiamo avuto modo di relazionarci con alcuni prodotti del NLP, come i virtual assistant e i chatbot, i quali forniscono risposte in maniera automatica alle nostre domande[12].

Per poter sviluppare nel concreto un assistente virtuale esiste una diversa complessità di sviluppo della soluzione e le aziende hanno a disposizione almeno tre diverse alternative tecnologiche[13]:

- Sviluppare un virtual assistant partendo da librerie software, quindi con soluzioni customizzabili e tailored made che vanno a rispondere nel dettaglio alle esigenze di un’azienda.

- Piattaforme: si tratta di ambienti di sviluppo che sono già stati preconfigurati per sviluppare una specifica soluzione.

- Applications: il riferimento è a quelle soluzioni che sono già state completamente programmate e configurate dai fornitori esterni e che possono essere immediatamente utilizzate nell’ambito di interesse dell’azienda.

Mentre le applications sono soluzioni limitate e predefinite, già pronte all’uso e facili da implementare, le librerie software, dal momento che andrà progettato l’hardware su cui verrà eseguita l’applicazione, possono rispondere in maniera più puntuale alle specifiche esigenze aziendali[14].

Si rileva[15], inoltre, che i chatbot possono essere classificati in diversi livelli: dal gradino più basso si parte con chatbot di livello 0, che si limitano a fornire delle risposte predefinite, mentre già al livello 1 i software cominciano a “capire” cosa chiede davvero l’utente. «Gli assistenti a livello 2 in su sono capaci di rispondere in maniera autonoma alle domande, attingendo anche a documenti esterni». Al livello 3 si registrano ulteriori progressi caratterizzati dalla capacità di memorizzare le informazioni e al livello 4 dalla capacità di comprensione e di adattarsi al contesto in cui viene posta una domanda, sino ad arrivare a un livello 5 dove addirittura «il virtual assistant riesce ad adattare le risposte al tono dell’interlocutore».

Nonostante il via a questo genere di sistemi sia stato dato dalla nascita del World Wide Web, il primo programma di “comunicazione” costruito tramite l’analisi del linguaggio naturale in passato è stato “Eliza”, descritto da Joseph Weizenbaum nel gennaio 1966. Questo “primo” chatbot aiutava l’utente ad esplorare i propri sentimenti e quotidianità, cioè era in grado di sostenere un dialogo con un essere umano, il software faceva le veci di uno psicoterapeuta[16]. Un altro esempio di chatbot non troppo recente risale al 1982 ed ebbe inizio con il progetto Jabberwacky che aveva lo scopo di creare un programma di intelligenza artificiale che simulasse una conversazione testuale umana nella speranza potesse superare il Test di Touring[17].

Per comprendere come nasce un chatbot è necessario introdurre brevemente un concetto preliminare costituito dalla rete Seq2seq[18] – creata da Google – che verrà utilizzata per addestrare il chatbot. Una rete Seq2seq ha principalmente due componenti: codificatore e decodificatore, motivo per cui la rete viene spesso chiamata Encoder-Decoder Network[19].

Si possono individuare tre componenti principali che caratterizzano la struttura di un chatbot:

- Natural Language Understanding (NLU)

- Dialog manager

- Contenuto (messaggi conversazionali)[20]

Le dimensioni degli input e degli output sono proporzionali alla dimensione della rete e al numero di layer utilizzati, quanto più il chatbot dovrà essere in grado di articolare frasi complesse, tanto più i layer dovranno essere numerosi. Una volta stabilito la tipologia di chatbot che si vuole creare, la parte più complessa del lavoro sarà trovare un buon dataset da “pulire”[21]. Costruita la rete Seq2seq usando lo strumento interattivo Tensorflow, definendo gli input, gli strati della rete, costruendo l’encoder e il decoder che permettono di renderla funzionante e, definendo gli output il cuore della rete è pronto, sarà necessario sottoporgli i dataset e iniziare la fase di apprendimento.

Uno snodo significativo nell’evoluzione dei chatbot è la possibilità di incrementarli con dati strutturati e non strutturati, attingendo anche da piattaforme esterne all’azienda. «In questo modo il virtual assistant ha la possibilità di restituire delle informazioni più appropriate e più profilate rispetto allo specifico utente, riuscendo persino a fornire dei veri e propri suggerimenti e consigli sulle future azioni da mettere in atto»[22].

Come abbiamo anticipato a più riprese in precedenza, i virtual assistant sono molto diffusi in parecchi ambiti e possono archiviare, trasferire e servirsi di informazioni captate nell’ambiente circostante e di una grande quantità di dati personali che hanno assunto un ruolo significativo, come quelli relativi alle comunicazioni elettroniche, agli stati emotivi, i dati biometrici e la geolocalizzazione, fornendo informazioni sui luoghi frequentati, sugli spostamenti e sulla loro frequenza. Questa mole di dati e informazioni, molto spesso, si riferisce non solo all’utilizzatore, ma anche a chiunque si trovi nello stesso ambiente. [23]

La crescita di tali competenze da parte delle applicazioni di IA (nel nostro caso virtual assistant e chatbot), alimentata dai dati, dai progressi degli algoritmi per l’apprendimento automatico, promette un grande valore aggiunto ma necessita di un approccio incentrato sulla prevenzione e attenuazione dei potenziali rischi del trattamento dei dati personali[24].

Le applicazioni “figlie” del NLP, essendo sistemi in cui all’incameramento dei dati segue un processo di autoapprendimento automatico, sono inclini per loro natura a trattare dati personali a prescindere dal compito per il quale sono stati indirizzati. Risulta cruciale verificare l’aderenza di tali applicativi ai principi del GDPR in quanto, ad esempio, sotto il profilo qualitativo la voce risulta essere un dato biometrico riconducibile ai dati particolari (o sensibili) di cui all’art. 9 GDPR. Inoltre, sotto il profilo quantitativo, tali trattamenti sono costituiti da un accumulo di dati rilevanti e ricadono sotto l’ambito di applicazione dei c.d. trattamenti automatizzati. Il GDPR mostra una particolare sensibilità ai “trattamenti automatizzati” di dati personali e in modo esplicito, tramite l’Art. 22, ribadisce che in relazione a queste tipologie di trattamenti le persone fisiche hanno il diritto di non essere soggette a una decisione basata esclusivamente su un’elaborazione automatizzata, compresa la profilazione, che produce effetti giuridici che le riguardano o che le interessano in modo significativo[25].

Dal dettato normativo sembrerebbe che nessuna applicazione di IA che comporti, o possa sfociare in decisioni automatizzate, possa essere pienamente compliant alla normativa europea senza prevedere un intervento umano almeno in seconda battuta, su richiesta dell’interessato. Sul punto si rileva[26] che le applicazioni di IA si muovono sempre più nella direzione di una interazione costante fra IA e intervento umano, anche perché è dimostrato che la percentuale di errore rilevato tra le soluzioni di IA ad oggi disponibili sul mercato è ancora molto elevato. I risultati delle operazioni di elaborazione e le decisioni che un applicativo di IA fornisce possono risultare distorte, rendendosi non solo inefficaci e fuorvianti ma anche dannose. L’interazione algoritmo/persona può quindi riequilibrare il Learning rate e migliorare significativamente le performance, rendendo, allo stesso tempo, gestibile l’attività di trattamento dei dati personali e il rispetto dei diritti in conformità a quanto disposto dal GDPR.

Si rileva[27] che un ulteriore criticità è rappresentata dalla difficoltà di definire stabilmente a priori tutte le finalità del trattamento: infatti, non è del tutto prevedibile ciò che l’algoritmo imparerà nel corso della sua vita. Tramite le funzioni del machine learning, l’applicativo di IA potrebbe iniziare di sua sponte a trattare dati per finalità ulteriori e diverse rispetto a quelle per quali è stato preordinato ab origine e «confliggere, in alcuni casi, con il principio generale[28] di finalità del trattamento di dati personali»[29].

In tali ipotesi, tutt’altro che remote negli attuali scenari, la distorsione ed estensione automatica delle finalità del trattamento si configurerebbe come un trattamento nuovo e non predeterminato che, non essendo più coperto dalle funzioni originariamente attribuite al sistema AI e illustrate all’interno delle condizioni d’uso e dell’informativa, risulterebbe slegato e quindi non più funzionale all’esecuzione del rapporto contrattuale e, pertanto, non più coperto da una idonea base giuridica e quindi illecito. «Questa circostanza, se non correttamente gestita, potrebbe entrare in conflitto con il principio di minimizzazione dei dati, essendo concretamente difficile determinare quali dati siano necessari».[30]

Le possibili criticità rilevate in relazione alle basi giuridiche potrebbero essere risolte usufruendo di un consenso rilasciato dall’interessato. Tale soluzione presenta delle criticità in quanto le soluzioni di AI non sempre consentono all’interessato di raccogliere agilmente un consenso informato, essendo nella maggioranza dei casi programmati per trattare dati senza dipendere dal consenso degli interessati coinvolti[31].

Il titolare del trattamento potrebbe optare per un bilanciamento di interessi tra il legittimo interesse e i diritti degli interessati sottesi al trattamento[32] anche se è stato evidenziato che in tali tipologie di trattamenti il bilanciamento si rivolge nella quasi totalità dei casi a favore della tutela dei diritti e delle libertà dei soggetti interessati.[33]

Rispetto all’informativa e ad un consenso informato, si segnala[34] che la menzione dell’esistenza di un processo decisionale automatizzato di per sé non pone l’interessato in condizione di comprendere la logica in base alla quale operano gli algoritmi né di misurare, in concreto, quale impatto e/o ingerenza possa prodursi nei suoi confronti. Di queste nuove attività il soggetto interessato raramente riesce ad averne consapevolezza e controllo non avendo a disposizione informazioni dettagliate sul trattamento che gli consentono di condurre scelte appropriate e di esercitare consapevolmente, pienamente e tempestivamente i propri diritti. Dall’altro lato, però, una informazione approfondita e dettagliata sul funzionamento dell’applicativo potrebbe vanificare gli sforzi economici e di know-how investiti per progettare e realizzare la soluzione stessa, soprattutto quando quest’ultima non può essere tutelata dall’avente diritto attraverso efficaci strumenti di proprietà intellettuale[35].

Dal momento che la tecnologia stessa deve essere preordinata sin dall’origine e progettata per svolgere le sue funzioni nel pieno rispetto dei diritti e delle libertà delle persone fisiche, l’art. 25 del gdpr, impone ai titolari del trattamento di preimpostare tali applicativi in modo da poterne mantenere il controllo in qualsiasi fase di evoluzione e sviluppo. Secondo tale principio di «privacy by design» la protezione dei dati dovrebbe essere implementata sin dalla fase di progettazione di qualsiasi[36] processo tecnologico e/o servizio che presuppone un trattamento di dati personali.

Tali applicativi dovrebbero operare nel rispetto dei requisiti minimi di aderenza alla normativa riducendo e limitando le caratteristiche e capacità identificative dei dati (alcuni dettagli forniscono maggiori informazioni di una persona rispetto ad altri)tramite le tecniche di pseudonimizzazione e minimizzazione individuate dallo stesso principio.

Dall’articolo 25 e dai considerando 75 e 76[37] ad esso collegati viene introdotto il risk based approach con il quale si quantifica a priori la responsabilità del titolare. Questo approccio introduce l’obbligo per il titolare del trattamento di effettuare un Data Protection Impact Assessment (“DPIA”) o valutazione di impatto del trattamento ai sensi dell’art. 35 del GDPR[38], dal momento che il trattamento di dati effettuato con tecnologie innovative (quindi senz’altro tutte le applicazioni del NLP) potrebbe comportare rischi privacy elevati.

Da ultimo, il principio di responsabilizzazione del titolare del trattamento[39] finisce per concludere quanto indicato dai precedenti principi enunciati, individuando nel titolare del trattamento il principale soggetto tenuto a darne completa attuazione nel concreto e fornire una prova di aderenza, se richiesto. Dal momento che in tali applicazioni esiste una pluralità di attori coinvolti (dal produttore dell’hardware, al fornitore del software, al fornitore dei servizi connessi attraverso piattaforme di Cloud Computing ecc.) non è sempre agevole suddividere correttamente le responsabilità rispetto ai processi che identificano i trattamenti e al flusso effettivo di dati personali, in quanto i ruoli (titolare- responsabili-) possono essere sovrapponibili, configurandosi situazioni di contitolarità e di corresponsabilità.

Premesso che da quanto riportato emerge la concreta difficoltà di calare le prescrizioni generali del GDPR nelle dinamiche tecniche di progettazione e nell’operatività di tali applicazioni, «un approccio nell’ottica del privacy by design attraverso una sinergia virtuosa di diverse competenze, permetterebbe un controllo preventivo di aderenza al Regolamento e dunque interno ai sistemi di AI e offrirebbe a valle una maggior chiarezza dei ruoli, coerenza e intellegibilità dei trattamenti in essere e delle rispettive responsabilità»[40].

Risulta in conclusione necessaria una governance equilibrata e responsabile di tali soluzioni da parte di tutti gli attori coinvolti per garantire la sicurezza e la riservatezza dei dati personali trattati. Come ribadito dalla Convenzione 108 del Consiglio Europeo: «la protezione della dignità umana e la tutela dei diritti umani e delle libertà fondamentali, in particolare il diritto alla protezione dei dati personali, sono essenziali nello sviluppo e nell’adozione di applicazioni IA che possono avere conseguenze sugli individui e la società».[41]

È evidente come le tecnologie basate sull’intelligenza artificiale rappresentino una grande opportunità perché promettono nuove capacità ed efficienze, come evidenziano le molteplici applicazioni nel campo del Natural Language Processing.

Tuttavia, ottenuti vantaggi tangibili ci si scontra con nuovi timori e sfide basate sugli effetti di queste tecnologie sulla vita delle persone. Queste preoccupazioni includono, altresì, la sicurezza e l’affidabilità delle tecnologie di IA, l’equità e la trasparenza dei sistemi e le influenze intenzionali e involontarie dell’IA sulle persone e sulla società.

Note

[1] F. Basile, “Intelligenza artificiale e diritto penale: quattro possibili percorsi di indagine”, DPU, Milano.

[2] F. Sarzana S. Ippolito, M. Nicotra, “Diritto della blockchain, Intelligenza artificiale e IOT”, IPSOA, 2018.

[3] COM (2018) 237 final.

[4] Ad esempio, assistenti vocali, software per l’analisi delle immagini, motori di ricerca, sistemi di riconoscimento vocale e facciale, COM (2018) 237 final.

[5] per esempio, in robot avanzati, auto a guida autonoma, droni o applicazioni dell’Internet delle cose, COM (2018) 237 final.

[6] Virtual assistant: ecco come possono diventare Expert advisor, BigData4Innovation, 30 settembre 2020, www.bigdata4innovation.it

[7] A. De Luca, “Big Data Analytics and Data mining”, IPSOA, 2018.

[8] The Ethics of AI and Emotional Intelligence “Data sources, applications, and questions for evaluating ethics risk”, Gretchen Greene, CPhil, MS, JD, Partnership on AI.

[9] S. Sensini, “Analisi del linguaggio con Python, imparare a processare testo e audio con le librerie open source”, Apogeo Editore, 2019.

[10] Alle macchine viene quindi insegnato non solo a leggere, analizzare e interpretare dei testi con modalità analoghe a quelle che utilizzano gli esseri umani, ma anche a “comprenderli” tramite l’elaborazione del linguaggio naturale, scritto e parlato.

[11] S. Sensini, op. cit.

[12] L’elaborazione del linguaggio naturale è la forza trainante dietro le seguenti applicazioni:

- Applicazioni di traduzione linguistica, come Google Translate.

- Elaborazione di testi attraverso Microsoft Word oppure Grammarly, che utilizzano l’elaborazione del linguaggio naturale per verificare l’accuratezza grammaticale dei testi.

- Applicazioni IVR (Interactive Voice Response) utilizzate nei call center per rispondere a determinate richieste degli utenti.

- Applicazioni ad assistente personale, come “OK Google”, Siri, Cortana e Alexa.

[13] Virtual assistant: ecco come possono diventare Expert advisor, BigData4Innovation, 30 settembre 2020, www.bigdata4innovation.it

[14] BigData4Innovation, op. cit.

[15] Idem su.

[16] Un esempio di comunicazione tra Eliza e un utente potrebbe essere il seguente. Utente: “Non mi piace la pizza.” Eliza: “Perché non ti piace la pizza?” Utente: “Ho sempre voluto fare lo chef…” Eliza: “Ti prego, continua” Utente: “Vorrei essere ricco!” Eliza: “Cos’altro ti viene in mente quando pensi a ciò?”.

[17] La capacità di un programma di simulare una conversazione scritta in tempo reale tra il sistema stesso e un giudice umano in modo sufficientemente realistico da non consentire al giudice di distinguere in modo affidabile – sulla base del solo contenuto della conversazione – ciò che ha prodotto il programma da ciò che produrrebbe un essere umano.

[18] S. Sensini, op. cit. “tipo di rete composta da un sistema encoder-decoder generico sviluppata all’interno della libreria Tensorflow, che può essere utilizzata per la traduzione automatica, il riepilogo del testo, la modellazione di chatbot e altro ancora. Come suggerisce il nome, Seq2seq prende in input una sequenza di parole e genera in output un’altra sequenza di parole, impiegando una rete neurale ricorrente (RNN).”

[19] Encoder: utilizza strati di reti neurali profonde e converte le parole di input in corrispondenti vettori nascosti. Ogni vettore rappresenta la parola corrente e il suo contesto. Decoder: prende come input il vettore generato dall’encoder, i suoi stati nascosti e la parola corrente per produrre il successivo vettore nascosto e infine prevedere la parola successiva.

[20] G. Altobello, “Natural Language Processing: come costruire un chatbot di successo”, ai4business.it.

[21] S. Sensini, op. cit. “non è possibile utilizzare i dati grezzi, ma occorre trasformarli in dati che il sistema sappia utilizzare, un modo potrebbe essere quello di creare un dizionario in cui a ogni chiave siano assegnate le parole estrapolate dalle conversazioni.”

[22] BigData4Innovation, op. cit.

[23] Assistenti digitali (smart assistant) i consigli del Garante per un uso a prova di privacy, Scheda informativa marzo 2020, www.garanteprivacy.it, 4 marzo 2020

[24] Linee Guida in materi di Intelligenza Artificiale e Protezione dei Dati- Comitato Consultivo (CD. T-PD) della Convenzione sulla Protezione delle persone rispetto al trattamento automatizzato di dati a carattere personale (“Convenzione 108”), Strasburgo, 25 gennaio 2019.

[25] «l’Interessato ha il diritto di non essere sottoposto a una decisione basata esclusivamente sul trattamento automatizzato dei propri dati che produca effetti giuridici che lo riguardano o che incida allo stesso modo sulla sua persona in modo significativo». Art. 22

Il comma 2 del medesimo articolo stabilisce che il primo paragrafo non si applica se la decisione «è necessaria per la conclusione o l’esecuzione di un contratto tra l’interessato e un Titolare del trattamento» (a); «è autorizzata dal diritto dell’Unione o dello Stato membro cui è soggetto il Titolare del trattamento e che stabilisce anche misure adeguate per salvaguardare i diritti e le libertà e gli interessi legittimi dell’interessato» (b); oppure, infine, «si basa sul consenso esplicito dell’interessato» (c)

[26] Intelligenza artificiale, ecco come il GDPR regola la tecnologia di frontiera, Renato Goretta, Agenda Digitale, 10 ottobre 2019

[27] Privacy and Tech Law, Privacy Differenziale al servizio della protezione dei dati, Newsletter ottobre / novembre 2020

[28] L’Art. 6 del GDPR, rubricato “Liceità del trattamento” stabilisce che un trattamento dei dati personali può avvenire, oltre che per finalità predeterminate, solo in presenza di idonee “basi giuridiche”. Se ad esempio il trattamento di dati personali è necessario al funzionamento di un assistente virtuale e al raggiungimento di determinati risultati preordinati, tale trattamento sarà lecito in esecuzione di un contratto tra titolare e soggetto interessato

[29] Machine learning, i problemi per la privacy (e le possibili soluzioni), Niccolò Anselmi, Giangiacomo Olivi, Agenda Digitale, 8 febbraio 2019

[30] Privacy and Tech Law, Privacy Differenziale al servizio della protezione dei dati, op. cit.

[31] Inoltre, il consenso deve essere sempre e in qualsiasi momento revocabile da parte dell’interessato mentre gli applicativi di IA sono spesso poco avvezzi a instradare correttamente una idonea procedura di revoca.

[32]art. 6(1)(f) del GDPR

[33] Niccolò Anselmi, Giangiacomo Olivi, Agenda Digitale, op. cit.

[34] Idem su

[35] «Il Considerando 63 del GDPR pur chiarendo che il titolare del trattamento dovrebbe fornire l’accesso remoto a un sistema sicuro che consenta all’interessato di consultare direttamente i propri dati personali, precisa che tale diritto non dovrebbe ledere il segreto industriale e aziendale e i diritti di proprietà intellettuale».

[36] Tale principio di neutralità tecnologica vuole essere il più aderente possibile allo scenario tecnologico attuale ma soprattutto al futuro progresso tecnologico potendosi applicare a qualsiasi fattispecie e adattandosi a qualsiasi opportunità.

[37] «La probabilità e la gravità del rischio per i diritti e le libertà dell’interessato dovrebbero essere determinate con riguardo alla natura, all’ambito di applicazione, al contesto e alle finalità del trattamento. Il rischio dovrebbe essere considerato in base a una valutazione oggettiva mediante cui si stabilisce se i trattamenti di dati comportano un rischio o un rischio elevato».

[38] GDPR, art. 35, comma 1: «Quando un tipo di trattamento, allorché prevede in particolare l’uso di nuove tecnologie, considerati la natura, l’oggetto, il contesto e le finalità del trattamento, può presentare un rischio elevato per i diritti e le libertà delle persone fisiche, il titolare del trattamento effettua, prima di procedere al trattamento, una valutazione dell’impatto dei trattamenti previsti sulla protezione dei dati personali».

Art. 35, comma 3 lett. a) La valutazione d’impatto sulla protezione dei dati è richiesta in particolare nei casi seguenti: “una valutazione sistematica e globale di aspetti personali relativi a persone fisiche, basata su un trattamento automatizzato, compresa la profilazione, e sulla quale si fondano decisioni che hanno effetti giuridici o incidono in modo analogo significativamente su dette persone fisiche;»

[39] Art. 5 GDPR

[40] Privacy and Tech Law, Privacy Differenziale al servizio della protezione dei dati

[41] Linee Guida in materi di Intelligenza Artificiale e Protezione dei Dati (“Convenzione 108”)

Bibliografia, sitografia e materiali consultati

- AI – ORIENTAMENTI ETICI PER UN’IA AFFIDABILE – Gruppo di esperti ad alto livello sull’intelligenza artificiale istituito dalla Commissione Europea nel giugno 2018 – documento reso pubblico in data 8 aprile 2019

- Analisi del linguaggio con Python, imparare a processare testo e audio con le librerie open source, S. Sensini, Apogeo Editore, 2019

- Assistenti digitali (smart assistant) i consigli del Garante per un uso a prova di privacy, Scheda informativa marzo 2020, www.garanteprivacy.it, 4 marzo 2020

- Big Data Analytics and Data mining, A. De Luca, IPSOA, 2018

- Bot, assistenti personali e chatbot: il customer service nell’era dell’AI, Annalisa Casali, digital4.biz, 12 aprile 2017

- Chatbot: cosa sono e cosa c’è dietro il loro successo, Gianluigi Torchiani, www.ai4business.it, 18 giugno 2018

- Chatbot e GDPR: un matrimonio impossibile? – Valentino Spataro, www.convcomp.it, 2 maggio 2018

- Comunicazione della Commissione al Parlamento Europeo, al Consiglio, al Comitato Economico e Sociale Europeo e al Comitato delle Regioni, L’intelligenza Artificiale per l’Europa, COM (2018) 237 final

- Conversational AI: le nuove frontiere dell’interazione uomo-macchina, Arianna Leonardi, ai4business.it, 5 dicembre 2019

- Cos’è l’intelligenza artificiale e perché se ne parla tanto? Lorenzo Govoni, Business e Tecnologia, lorenzogovoni.com

- Diritto della blockchain, Intelligenza artificiale e IOT, F. Sarzana S. Ippolito, M. Nicotra, IPSOA, 2018

- Gli assistenti virtuali? Sì, sono il futuro, Gianluca Maruzzella, https://blog.indigo.ai/

- Intelligenza artificiale, ecco come il GDPR regola la tecnologia di frontiera, Renato Goretta, Agenda Digitale, 10 ottobre 2019

- Intelligenza artificiale e diritto penale: quattro possibili percorsi di indagine, F. Basile, DPU, Milano

- L’Overfitting e l’Underfitting nel machine learning, Lorenzo Govoni, Business e Tecnologia, lorenzogovoni.com

- Linee Guida in materi di Intelligenza Artificiale e Protezione dei Dati- Comitato Consultivo (CD. T-PD) della Convenzione sulla Protezione delle persone rispetto al trattamento automatizzato di dati a carattere personale (“Convenzione 108”), Strasburgo, 25 gennaio 2019

- Machine learning, i problemi per la privacy (e le possibili soluzioni), Niccolò Anselmi, Giangiacomo Olivi, Agenda Digitale, 8 febbraio 2019

- Natural Language Processing: come costruire un chatbot di successo, G. Altobello, ai4business.it

- POLICY AND INVESTMENT RECOMMENDATIONS FOR TRUSTWORTHY AI – High-Level Expert Group on Artificial Intelligence, 26 giugno 2019

- Proposte per una strategia italiana per l‘intelligenza artificiale (luglio 2019)

- Privacy and Tech Law, Privacy Differenziale al servizio della protezione dei dati, Newsletter ottobre / novembre 2020

- Raccomandazione CM / Rec (2020) 1 del Comitato dei Ministri agli Stati membri sugli impatti sui diritti dell’uomo dei sistemi algoritmici, adottata l’9 aprile 2020

- Relazione Della Commissione al Parlamento Europeo al Consiglio e al Comitato Economico e Sociale Europeo (FEBBRAIO 2020): relazione sulle implicazioni dell’intelligenza artificiale, dell’internet delle cose e della robotica in materia di sicurezza e di responsabilità

- Strategia Nazionale per l’Intelligenza Artificiale (luglio 2019)

- The Ethics of AI and Emotional Intelligence “Data sources, applications, and questions for evaluating ethics risk”, Gretchen Greene, CPhil, MS, JD, Partnership on AI

- Virtual assistant: ecco come possono diventare Expert advisor, BigData4Innovation, 30 settembre 2020, www.bigdata4innovation.it

Autori